画像テキストの翻訳

U+ 6:26 ‘;

4

役職

英語原文のGoogle翻訳

これはクレイジーです

サムスンの新しいAlモデル。ディープシークとジェミニ

2.5 Pro、ARC-AGI 1 と比べて 10,000 倍小さい

2 はい、先へ

Samsung の超小型再帰モデル (TRM) は一般的なモデルです。

LLM の約 10,000 分の 1 ですが、単なるテキストです

私たちは予測ではなく再帰的に考えるので、さらにそうです。

賢いですね。まず、回答の下書きを作成してから、次のことを行います。

推論のために隠した

「スクラッチパッド」フレームワークを構築し、

論理枠組みの批判と改善を繰り返すことで(最大16回)、

各サイクルで、改善された答えを導き出します。

このアプローチは、(サイズだけでなく) アーキテクチャと推論ループに依存します。

それは知性を高めることができることを示しています。

強力かつ効率的なモデルを低コストで構築

実行したり、神経記号のアイデアを検証したり、その他の機能を実行します。

最高品質の推論をさまざまなアプリケーション分野に適用します。

お手伝いさせていただきます:

加速はどこにでもあります

返信を投稿する

U+ 6:26 ‘;

画像テキストの翻訳

0

22

役職

少ないほど良い: Kecursive

からかい

ネットワーク

アレクシア・ジョリクール=マルティノー

サムスン SAIL モントリオール

アレクシアジョサムスンコム

抽象的な

CrCr;オルトラピーロス

8

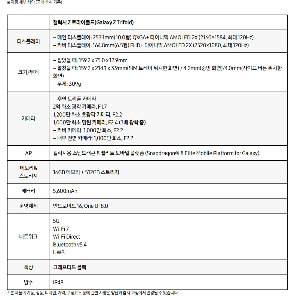

階層的推論モデル (HRM) は

2 つの小さな反射ネットを使用した新しいアプローチ

フニンレン

エンブディルグ

さまざまな周波数で動作します

これ

8

生物学にヒントを得た方法でラージラーを破る

ハード パズル タスクのゲージ モデル (LLM)

Sudoku Maze、ARC-AGI など

追加と標準化

小さなモデル (2,700 万パラメータ) でトレーニング

MLP

少量のデータ (~ I(N 例) の HRM が保持

困難な問題を解決する大きな約束

援助

ノルム」

小さなnctworks

でもまだ良くない

8

わかっていますが、最適ではない可能性があります

私たちはプロです

SLL ウェンボン

ポーズ

再帰的モデル

(IRM)

多くの

より単純な再帰的推論アプローチ

大幅に高い一般化を達成する

HRM よりも、使用中に

シンスル

ネットワーク

いんぷ(雨)

予測 (yI

ラレンル (z

CJe SuD7I

IAnswerl

イラソニナル

だけで

レイヤーのパラメータはわずか 700 万個。

TRM は ARC ACI で 4596 のテスト精度を達成

ARC-AGI-2 ではほとんどの製品よりも高い 876

L.L.M.

Decpseek Ri o3-mini Gemini 25

O01%6 未満のパラメータ

ステップ

ウルダーア

与えられた ^

mpyove (HDウロニリ)

‘

1. はじめに

出来ない

「ウナピエドグォニ?

その間

強力なラージ言語モデル (LLM) は、

難しい質疑応答に苦戦する

問題g

与えられた

アンロイ・ヌサス

16 ティモフ

miptorfy tnu erudicton y)

彼らはそこで自己回帰的に自分の答えを尊重します

以来エラーが発生しています

siriele 間違ったトークンが存在する可能性がある

ジャクソン・アトキンス

ジャクソンアトキンス

19:00

脳が壊れたとき

この論文を読んでください

小さな 700 万パラメータ モデルがちょうど勝てる

DeepSeek-R1、Gemini 2.5 pro、および 03-mini では

ARG-AGI1 と ARC-AGI 2 の両方に関する推論

少ないほど良い: 再帰的

との推論

ネットワーク

アレクシア・ジョリクール=マルティノー

サムスン SAIL モントリオール

アレクシア・ジョサムスン・コムン

抽象的な

‘クロスontrcpy

8

階層的推論モデル (HRM) は

2 つの小さなニューラル ネットワークを使用した新しいアプローチ

フヴァルグト

エムンボディリヤ

異なる周波数で再帰的に動作します。これ

8

生物学的にインスピレーションを得た覚せい剤(ydがラージ・ランを破る)

ハード パズル タスクのゲージ モデル (LLM)

そんなDS 数独迷路;およびARC AGI

援助しない

小さなモデル (2,700 万パラメータ) でトレーニング

NLP

小規模データ (~I0O の例) については、HRM が保持します

5

困難な問題を解決する大きな約束

オード

または

小規模なネットワーク、

でもまだ良くなっていない

S6l-アトントン

わかっていますが、最適ではない可能性があります

私たちはプロです

7

U4

TIV 再帰的ミューデル (TRM)

多くの

返信を投稿する

小さい

イイニ

テニー

(eb

プロ)

イティグ

小さい

鍵となる発見:超微粒子Al、TRMの驚異的な力

画像テキストの翻訳

この研究の核となるのはTRM(Tiny Recursive Model)です。

これは新しいアプローチです。 TRMは人間にとって困難な問題を解決します。

前と同じように、一度に答えを与えるのではなく、自分自身で答え続けてください。

推論プロセスを見直して改善する「再帰的」

メソッドを使用します。

圧倒的な効率性: TRM がサポートするパラメータは 700 万のみ

画像テキストの翻訳

Turtle は、数千億のパラメータ名を持つ最新の巨人です。

これは、Al モデルのサイズの 0.0% 未満です。

人間レベルの推論能力:スドグの迷路と詩

ARC-AGI、純粋な推論能力を測定する究極のテスト

ベンチマークと同様の高レベルのパフォーマンス。問題では; TRMが一番

大規模な言語モデルを圧倒するようなパフォーマンスはありません。

ARC-AGI-1 テストでは、TRM は **44.69** の精度を達成しました。

フレームを記録することで、 Gemini 2.5 Pro、世界最高のモデル

(37.096) 枠を超えることはできません。 ARC-AGI-2 の 7.89 フレームの月

あなたのもの。これも Gemini 2.5 Pro (4.996) と既存のモデルです

この数字はHRM(5.09)を上回ります。

サムスンは超大型モデルを作らなかったことで批判された。

オンデバイス向けの Ai を掘り下げながら新しい学習アルゴリズムを作成する